| 年小组动态 |

| 其它年份小组动态 |

|

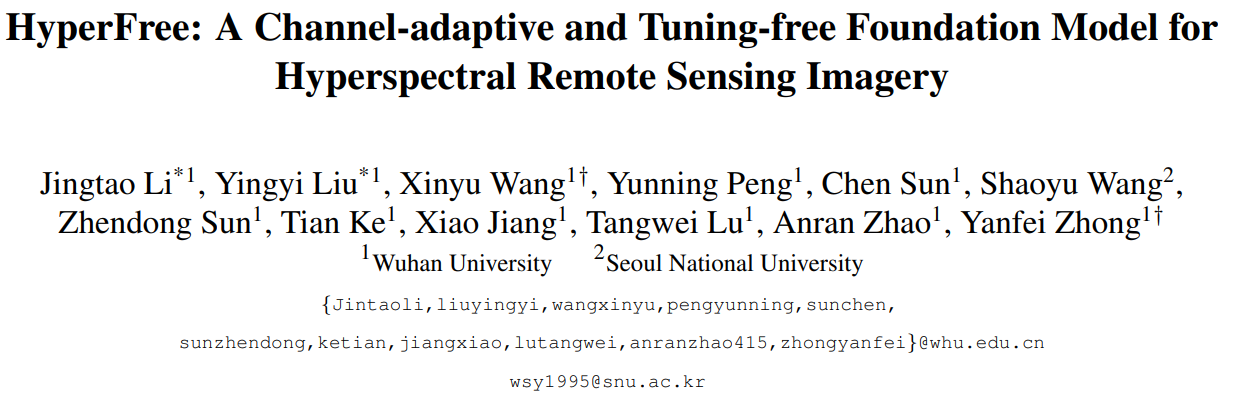

论文标题:HyperFree: A Channel-adaptive and Tuning-free Foundation Model for Hyperspectral Remote Sensing Imagery

项目网站:https://rsidea.whu.edu.cn/hyperfree.htm

论文:https://rsidea.whu.edu.cn/HyperFree.pdf

代码:https://github.com/Jingtao-Li-CVer/HyperFree

收录会议:CVPR 2025

关键字:

最大规模的高光谱遥感分割数据引擎Hyper Seg,1544万对象级掩码标签;

首个变长波段自适应的高光谱遥感基础模型,支持任意光谱维度的影像数据输入;

首个具备免微调迁移能力的高光谱遥感基础模型,支持多分类、单分类、目标探测、异常探测、变化检测等5大任务应用。

研究背景

当前,基础模型的发展将遥感解译能力推向了新的高度,但现有研究主要聚焦于高分辨遥感影像。高光谱遥感影像因其成像波段多变、易受成像条件影响等特性,导致高光谱基础模型的研发面临显著挑战,具体表现为以下两方面:

(1)高光谱影像波段多变性与视觉架构固定输入之间的矛盾:高光谱影像的波段数量变化范围较大,从几十到几百不等,而现有基于深度学习的视觉架构在训练完成后仅支持固定数量的输入波段,难以适应高光谱数据的多样性。

(2)高光谱影像地物特性多变与逐影像微调资源消耗之间的矛盾:不同时刻、光照条件下的高光谱影像中地物光谱特性差异显著,主流自监督学习方法需逐影像微调,导致硬件(如80G显存)和时间(小时级)成本高昂,限制了其实际应用。

针对上述挑战,武汉大学RSIDEA团队提出了首个无需微调的高光谱遥感基础模型HyperFree。该模型创新性地实现了从谱段固定编码到动态编码、从逐影像微调到统一可提示迁移的转变,支持任意波段高光谱遥感影像的多任务直接推理,显著提升了模型的灵活性与效率。

|

|

|

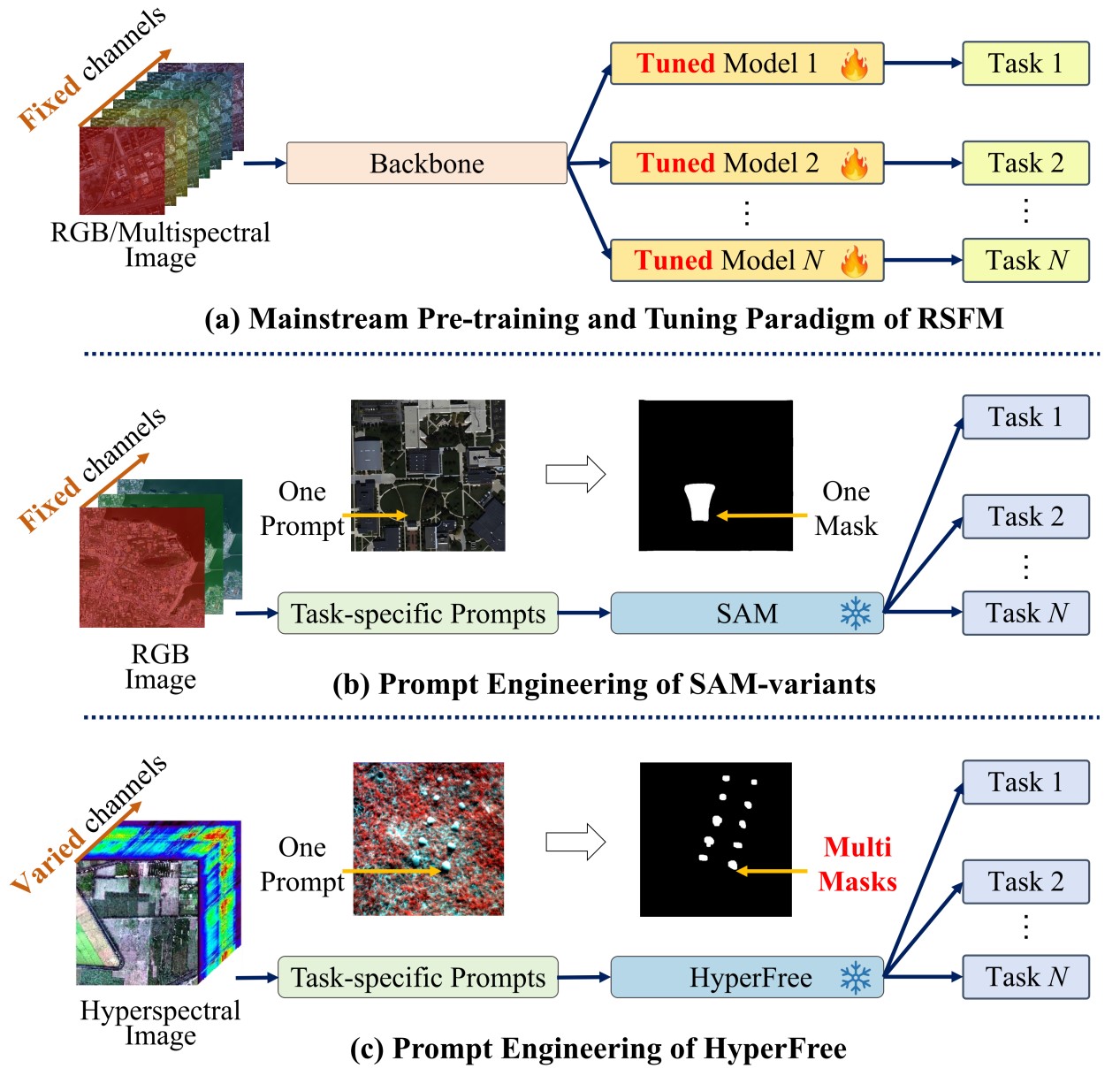

图1 HyperFree与主流遥感基础模型的范式差异(a)遥感主流的预训练-微调基础模型。(b)高分领域免微调的可提示基础模型。(c)HyperFree波段自适应、免微调的可提示基础模型。

|

主要创新点

1. 数据层—Hyper-Seg数据引擎

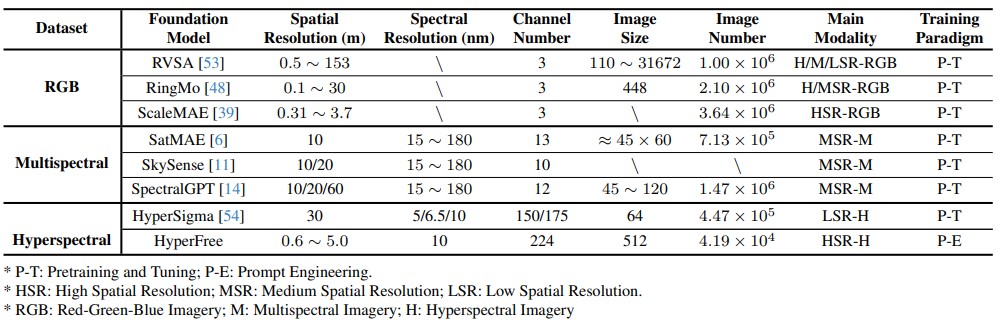

构建了目前规模最大的高光谱遥感语义分割数据引擎Hyper-Seg,包含4.1万对高光谱遥感影像与其对应的对象级分割标签,对象级标签数量达1544万。

影像尺寸为512×512×224,光谱范围400~2500nm,空间分辨率0.6~5m。

该数据引擎可为基础模型提示学习预训练提供重要的数据基础。

|

|

|

图2 Hyper-Seg数据引擎

|

|

表1 现有遥感基础模型及其训练数据集

|

|

|

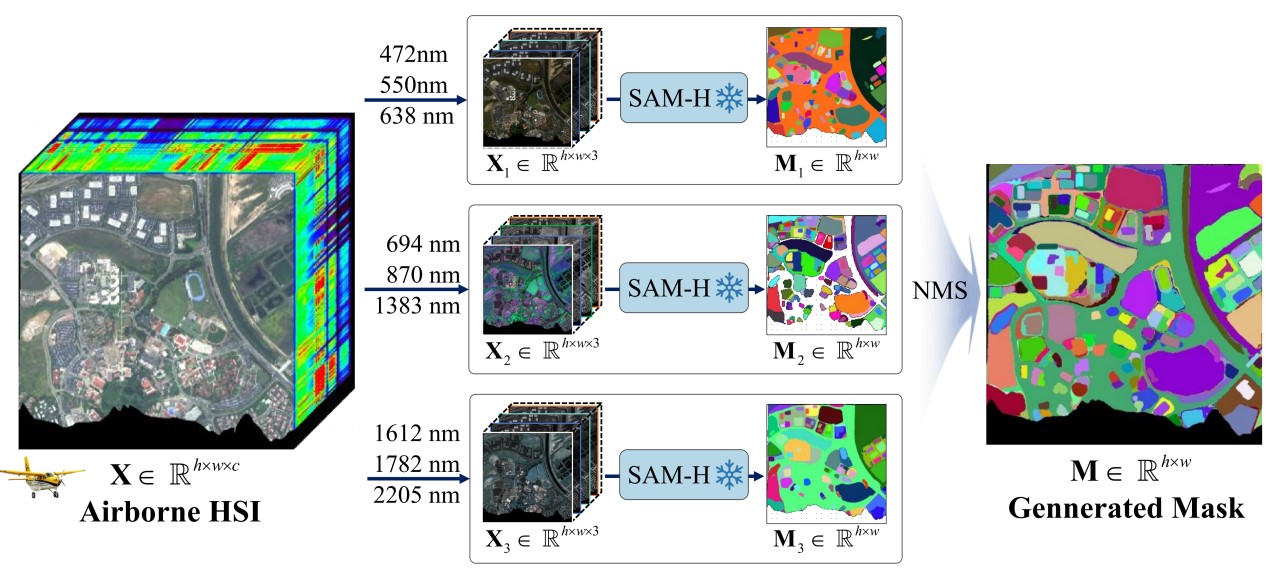

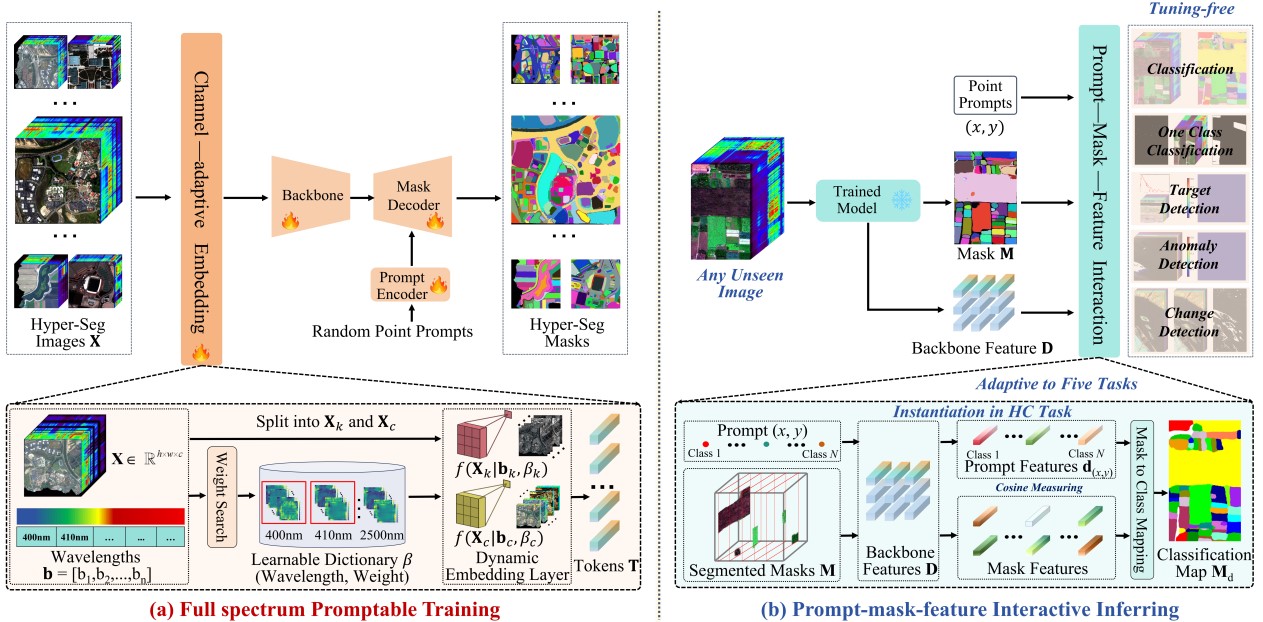

2. 编码层—波段自适应的全谱段统一编码

引入可学习的全谱段光谱权重字典(400~2500nm),以中心波长为索引,对不同波段数的高光谱影像进行动态编码,映射到统一维度的特征空间,如图3(a)所示。

突破遥感基础模型固定输入通道数的限制,实现任意中心波长、波段高光谱影像的统一表达。

|

|

|

图3 (a)全谱段提示预训练过程。(b)提示-掩码-特征交互机制下的多任务免微调推理。

|

3.免微调—基于提示工程的多任务迁移

Hyper-Seg数据引擎预训练后,HyperFree可自动生成任意高光谱影像的对象级分割掩码;

设计提示-掩码-特征交互机制,实现单个提示(One Prompt)→语义一致多分割掩码(Multiple Masks)的自动生成。

支持多分类、单分类、目标探测、异常探测、变化检测等5类任务的免微调迁移。

性能突破

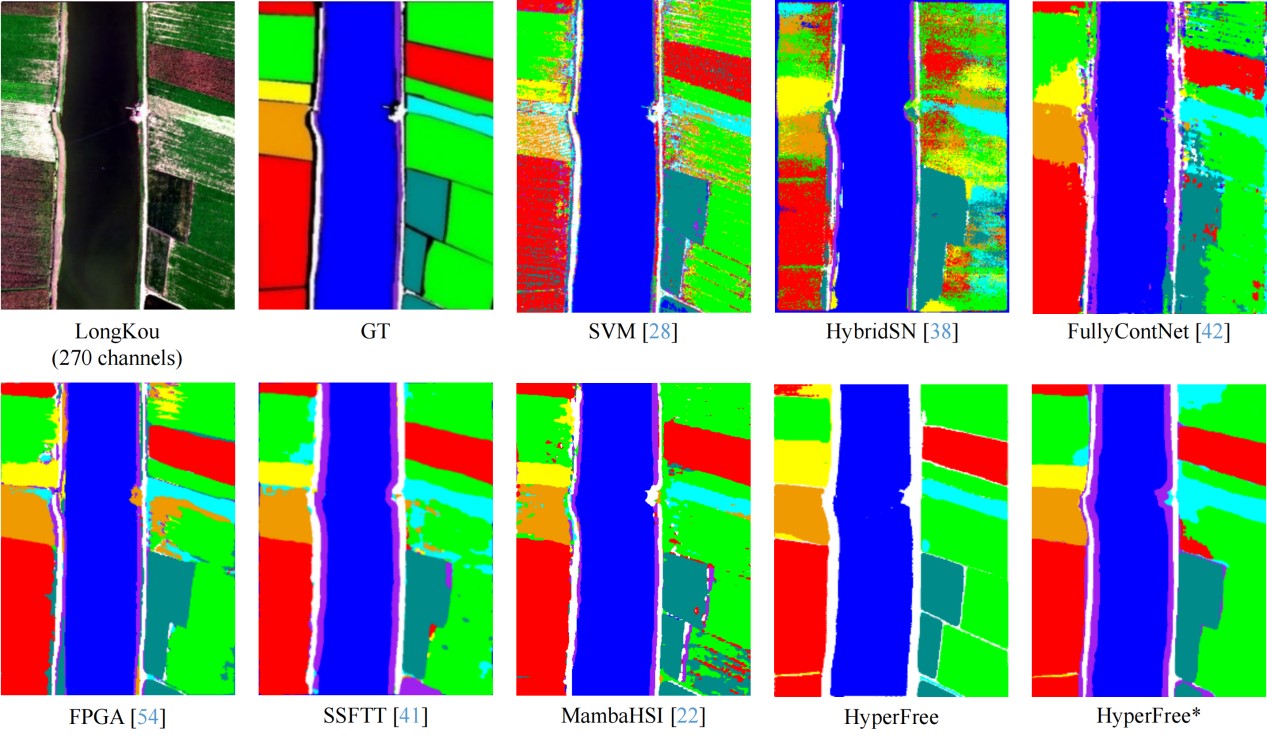

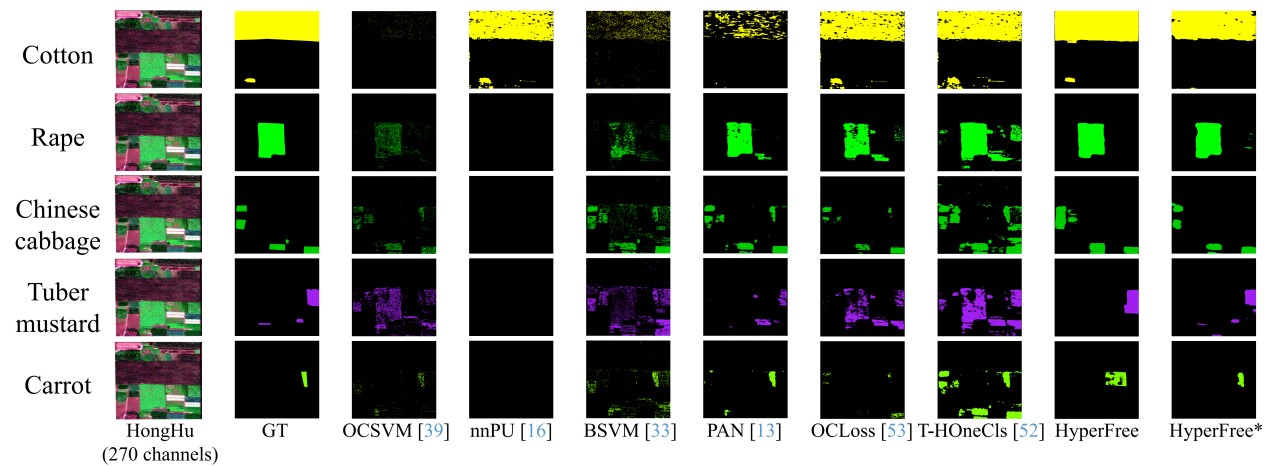

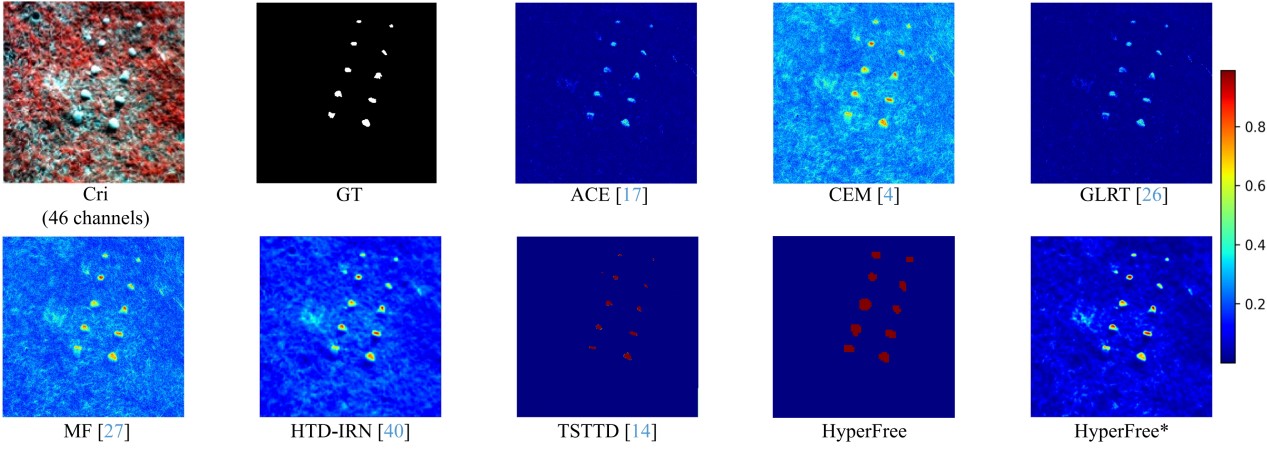

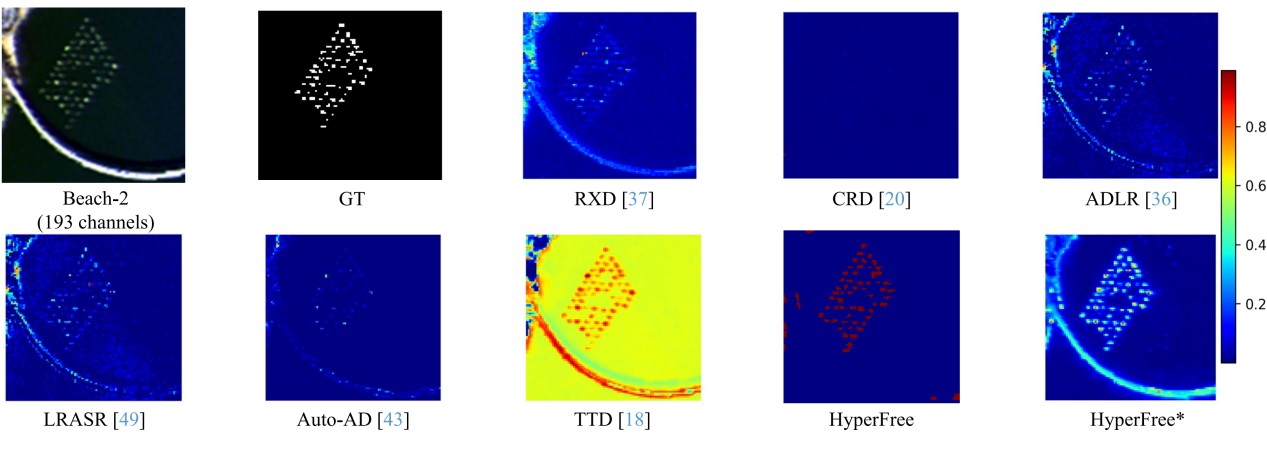

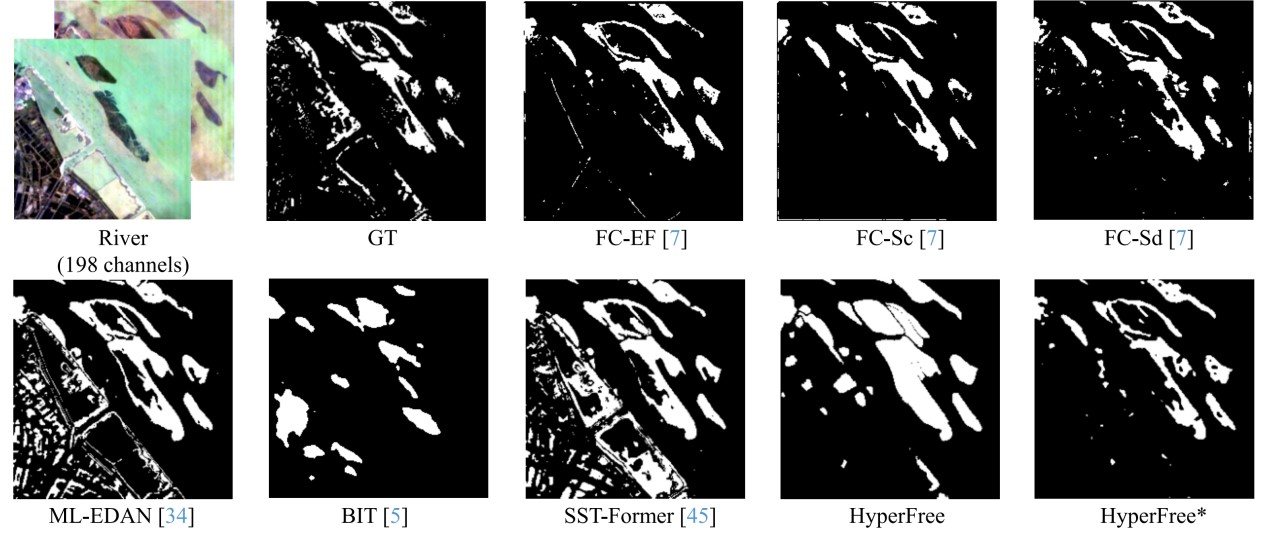

免微调设置下: 如图4(a)所示,HyperFree在多分类、单分类、目标探测、异常探测、变化检测等监督、半监督、无监督等分割任务上具备免微调直接应用迁移能力,达到与专业模型(5-shot微调)相当水平。

多分类任务:闭集设定下:为每个类别输入点提示(数量≥1),无需任务参数;开集设定下:为每个已知类别输入点提示(数量≥1),余弦距离参数控制未知类别相似度边界。

单分类任务:为目标类别输入点提示(数量≥1),类别先验参数与余弦距离参数控制地物掩码选择边界。

目标探测任务:为目标类别输入单个光谱曲线,余弦距离参数控制地物掩码选择边界。

异常探测任务:无需提示信息,地物占比参数控制异常地物筛选标准。

变化检测任务:无需提示信息,余弦距离参数控制地物变化认定标准。

微调设置下:HyperFree*在8个任务、14个数据集上,与专业模型比达到最优水平。包括高光谱去噪、分类、单分类、异常探测、变化检测、目标探测、解混、目标跟踪等任务,如图4(b)所示。

11个数据集、5类任务上的实验表明:

免微调下与专业模型(5-shot微调)相比达到中上水平

|

|

|

图4 (a)免微调设置下的精度对比。(b)微调设置下的精度对比。

|

|

|

|

图5 高光谱分类任务结果示例(对比方法5-shot微调 vs HyperFree免微调)

|

|

|

|

图6 高光谱单分类任务结果示例(对比方法5-shot微调 vs HyperFree免微调)

|

|

|

|

图7 高光谱目标探测任务结果示例(对比方法1-shot微调 vs HyperFree免微调)

|

|

|

|

图8 高光谱异常探测任务结果示例(对比方法无监督微调 vs HyperFree免微调)

|

|

|

|

图9 高光谱变化检测任务结果示例(对比方法5-shot微调 vs HyperFree免微调)

|

研究团队

该成果是武汉大学RSIDEA高光谱遥感研究团队在前期研究基础上的重要拓展与延伸,凝聚了团队师生的集体智慧与协作精神,历时一年攻关完成。研究由王心宇副教授与钟燕飞教授共同指导,博士生李静涛与硕士生刘颖怡作为共同第一作者,分别主导了基础模型与数据引擎的构建工作,为研究的核心框架奠定了坚实基础。团队成员彭韵凝、王少宇、孙晨、孙振东、柯天、姜枭、鲁唐伟、赵安然等分工协作,高效完成了单分类、多分类、目标探测、异常探测、变化检测、图像去噪、混合像元分解及目标跟踪等8项下游解译任务的测试工作,充分展现了团队在技术攻关与任务执行中的协同能力。同时,该研究得到了国家自然科学基金青年科学基金项目(A类,42325105)和博士生青年科学基金项目(424B2010)的支持。

|

供稿:李静涛 排版:柯天 审核:吴娇、王心宇